Diese Entwicklung von Forschern des MIT „Computer Science and Artificial Intelligence Laboratory“ hat durchaus ihren Charme für alle, die sich mit Animation und 3D-Rendering beschäftigen. Ein konkretes Beispiel, welches auch im unten folgenden Video zu sehen sein wird: Ein per Video aufgenommener Busch mit Dutzenden Verästelungen und Tausenden Blättern wird durch das Ziehen mit der Maus ganz einfach in realitätsnahe Bewegung versetzt. Ohne 3D-Modell, ohne langwierige Entwicklung von „Busch-Bewegungsintelligenz“.

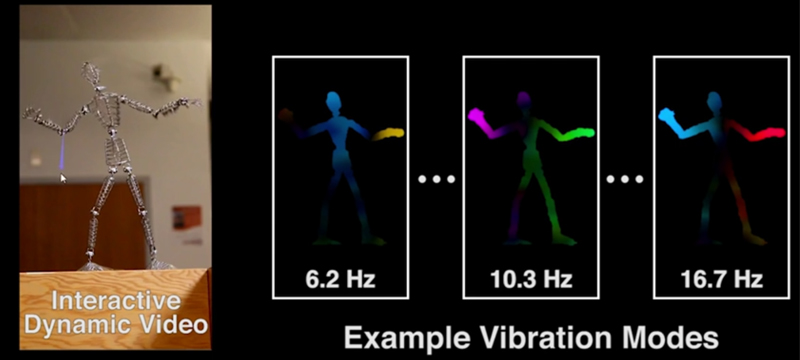

Was man dafür benötigt? Im Wesentlichen ein Stativ und eine Kamera. Wie das funktioniert? Besagter Busch wird über eine gewisse Zeit (hier eine Minute lang) aufgenommen, wobei es wichtig ist, dass er vibriert, was mit ein bisschen Wind relativ einfach zu erreichen sein sollte. Anschließend wird das Video automatisch analysiert und dem Objekt werden verschiedene „Vibration Modes“ zugeteilt. Werden nun noch die Formen und die Frequenzen dieser Modi ausgelesen, kann daraus abgeleitet werden, wie sich das Objekt in „neuen“ Situationen verhalten würde.

Die Erklärungen im zugehörigen Clip beginnen dabei mit einem Drahtmodell, welches für fünf Sekunden aufgenommen wird. Ein Schlag auf den Tisch und das Männlein gerät in Vibration – diese kurze Sequenz soll genügen, damit man es anschließend mit einem Mausziehen fröhlich bewegen kann (Minute 1:15 im Video).

Noch weiter geht es dann, wenn computeranimierte Charaktere mit „der echten Welt“ interagieren sollen (zu sehen ab Minute 3:09). Bei großen Animationsstudios mit ordentlich Budget kein Problem: In die reale Umgebung werden einfach weitere, virtuelle Elemente eingefügt, mit denen die Charaktere dann kollidieren und Dynamisches auslösen.

Mit der neuen Entwicklung sei es nun aber möglich, animierte Charaktere (im Video sind das mit Paint gezeichnete Figuren) direkt mit echten Elementen in Interaktion treten zu lassen. So hüpft beispielsweise ein Alien-Roboter auf eine Brücke, die dann entsprechend reagiert. Dieses und viele weitere Beispiele:

Hier geht es zur Projektseite von „Interactive Dynamic Video“. Das Verfahren wurde vom MIT patentiert und hat noch nicht den Weg in ein kommerzielles oder anderweitig zur Verfügung gestelltes Produkt gefunden.

Euer Jens

Bildquelle: Screenshots aus dem Video "Interactive Dynamic Video" von Abe Davis´s Research