Den Vordergrund ins Töpfchen, den Hintergrund ins Kröpfchen – eine vielfach gestellte Aufgabe in der Filmproduktion wie auch in der Fotobearbeitung. Mit anderen Worten: Es soll freigestellt, möglichst akkurat ausgeschnitten werden, damit sich Personen, Tiere und Objekte in einer völlig anderen Umgebung wiederfinden.

Der Anforderungsgrad variiert und kann von wenigen Klicks bis hin zu minutenlanger Filigranarbeit sicherlich alles umfassen. Kommt eben darauf an, ob da ein kantiges Objekt mit klarer Kontur zum Hintergrund auf eine eigene Ebene transportiert oder ob eine eher fein- und vielhaarige Angelegenheit aus einem hochtexturierten Hintergrund ausgeschnitten werden soll. Zumindest wenn es im Dahinten eintönig, zum Beispiel weiß, grau, schwarz, grün oder blau zugeht, vereinfacht das das Handanlegen mit Photoshop und Co. ungemein.

Was nun aber wäre, wenn ein Klick zur perfekten Freistellung genügt, völlig unabhängig vom vorgegebenen Vorder- und Hintergrund? Wenn sich also das kantige Objekt vor einem Greenscreen ebenso einfach freistellen ließe wie das Haarwirrwarr vor einem Laubwald? – Genau daran arbeiten Forscher vom Beckman Institute for Advanced Science and Technology, von der University of Illinois at Urbana-Champaign und von Adobe Research.

Deren unlängst publizierter Artikel (öffnet PDF) verspricht aktuell zwar noch keine für die Praxis umgesetzte Anwendung, doch präsentiert er genau dies: automatisiertes Freistellen, unabhängig vom jeweiligen Bildinhalt. Gibt es zwar schon, doch nun soll der Prozess noch besser funktionieren. Dafür notwendig sei, dass die der Auswahl zugrunde liegenden Algorithmen mehr als nur die Farbinformation eines Bildes betrachten. Stattdessen sollten strukturelle und semantische Eigenschaften des Bildes bei der Analyse eine primäre Rolle einnehmen.

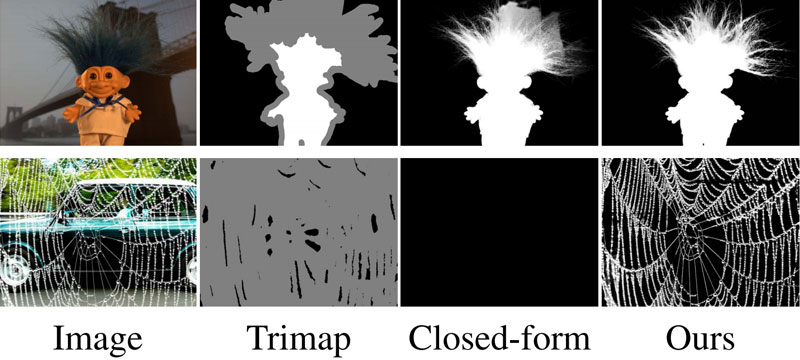

Der von den Forschern vorgestellte Prozess ist zweistufig, wobei zunächst eine eher grobe Auswahl erstellt wird, welche anschließend verfeinert wird. Dabei kommt in beiden Schritten ein Convolutional Neural Network zum Einsatz, die Abläufe basieren also auf Methoden des maschinellen Lernens. Im Titelbild oben zu sehen: Links die Ausgangsbilder, daneben die Trimaps (Unterteilung eines Bildes in Vordergrund, Hintergrund sowie einen unbekannten Bereich), daneben die Ergebnisse eines sogenannten Closed-form-Verfahrens, ganz rechts die Resultate des neu entwickelten Prozesses.

Ob und wann die Entwicklung übergeht in ein nutzbares Tool ist noch nicht bekannt.

Euer Jens

Bildquelle Vorschau und Titel: Aus der Veröffentlichung "Deep Image Matting" von Ning Xu, Brian Price, Scott Cohen, and Thomas Huang (PDF)