In diesen auf der Adobe MAX vorgestellten Sneak Peeks wird zunächst das inhaltsbasierte Füllen aufgewertet. Erst „versteht“ die Funktion, was da im Bild zu sehen ist, dann wählt sie auf breiterer Datenbasis Elemente aus, die für das Füllen verwendet werden. Darunter ein Beitrag, in dem der Stil einer Vorlage auf ein Porträt übertragen wird.

Inhaltsbasiertes Füllen „versteht“ den Bildinhalt

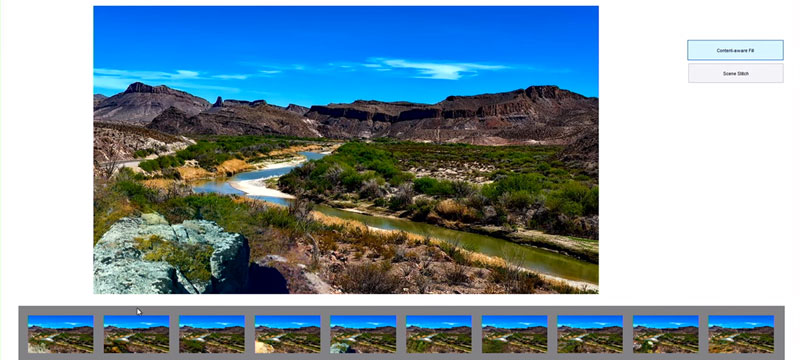

Beim inhaltsbasierten Füllen mittels Photoshop wählt man zunächst den Bereich aus, der durch einen neuen, möglichst passenden Bildinhalt ersetzt werden soll. Die Funktion sucht anschließend im Bild nach Elementen, die zum Füllen geeignet sind. Das funktioniert mal gut, mal weniger gut.

Eine Herausforderung: Bislang basiert die Auswahl der „geeigneten Elemente“ auf der Analyse von Pixelwerten. „Project Deep Fill“ geht das an und integriert mittels Adobe Sensei auch eine semantische Auswertung der Bildinhalte. Die Algorithmen „verstehen“ also, was da im Bild zu sehen ist, und können weitaus bessere Entscheidungen treffen.

Die Ergebnisse sind im Video bei Minute 1:56 und 3:40 zu sehen (links jeweils das Original, rechts das Resultat des aktuellen inhaltsbasierten Füllens, in der Mitte das Ergebnis von „Deep Fill“).

Euer Jens

Bildquelle Vorschau und Titel: Screenshot aus dem Video "#ProjectSceneStitch: Adobe MAX (Sneak Peeks)" von Adobe Creative Cloud